AIが嘘をつく?

こんにちは、しろやぎです!

最終日の今日は知的好奇心をくすぐるお話をしたいと思います

ええ、この際だから三日坊主ネタは最後までひっぱりますよ( ^ω^)

さて

Twitterでは毎日TLがChatGPTで溢れかえっています

まさにAIバブルです

そんなAI狂乱の中

「AIは嘘をつく」

「ファクトチェックが必要なので手間だ」

などという意見をよく見かけます

そんな意見を見て

「ああ、AIってまだそんなレベルのおバカさんなんだ」

「今触らなくてももう少し性能が上がってからでいいかな」

と考えるのはもしかしたらもったいない考え方かもしれません

確かにAIは、さも当然のことであるかのようにしれっと間違えた知識を披露することが多々ありますが

それが即ち

「人間より劣っている」

「まだ性能が悪い」

と考えるのはAIの本質を見誤ることに繋がるかなと私は思います

この記事では、AI(とりわけ大規模言語モデルについて)の仕組みを理解することで

AIがなぜ嘘をついてしまうのか、解説したいと思います

実はAIの理論自体は非常に単純なようです

この記事を読んだ方が

あ、そんなに難しいことをしてるんじゃないんだな

とAIへの苦手意識を払拭し、AIの可能性について

ポジティブなイメージを持ってもらえれば嬉しいです

では早速解説していきましょう!

AIの仕組み

AI(とりわけ大規模言語モデル)とは

先日も記事にした通り

ChatGPTは人とAIの自然な対話を実現するために生まれました

さまざまな質問や要求に対応できる能力を持っています

ChatGPTの登場よって、人間は日常の会話から専門的な知識まで幅広いトピックについて

会話するようにAIとやり取りすることができるようになりました

現在騒がれているAIと呼ばれているもののほとんどは

大規模言語モデル(Large Language Model)

と呼ばれるものです

ちょうど大規模言語モデルについてのとても良い記事があったので紹介します

時間のある方は是非読んでみてください

これを読めばなぜAI達がなぜ

「大規模言語モデル」

と呼ばれるのか理解できるようになるはずです

「機動戦士」と聞いたら「ガンダム」と答えてしまうのがChatGPT チャットAIをブレスト相手にするために理解しておきたいこと

大規模言語モデルの中で行われていること

さてこの記事に書かれているAIの仕組みについて

要点を大雑把にかいつまんで言うと

大規模言語モデルは突き詰めると

「ある単語の次にどの単語が来るか、確率の高い順に並べているだけ」

とのことです

仮に

赤い

という単語があったとしましょう

この単語の次に続くのは

トマト・リンゴ・信号

あたりが可能性高そうですね

そのままであれば

赤いトマト

といった文章が出力されることでしょう

ところがこの「赤い」の前に

ジオンの

という文がはいったらどうなるでしょう?

「トマト」「リンゴ」「信号」を差し置いて

彗星

が次に並ぶ単語の候補としてトップに躍り出て

大規模言語モデルは

ジオンの赤い彗星

と出力するわけです

ものすごく性能の良い予測変換のようなものですね

この様に大規模言語モデルは

世界中の言語の単語同士のつながりの確率と

分脈による単語の出現度合いを途方もない量のデータから学習しているのです

だから「大規模言語モデル」という名前なんですね

理屈でいえば簡単ですが実現のためには膨大な量の計算が必要になります

近年、技術の進歩でこの計算の実行に目途が付いたために

急速に大規模言語モデルが進歩したそうです

今をときめくAIも一皮むいてしまえば

「技術の進歩による究極の力業」

もいいところなのです

「AIの中身がブラックボックスだ」

という話は聞いたことがあるかもしれません

その理由は上記の内容でご理解いただけるかなと思います

扱うデータと実行される計算が多すぎて

いったいどのような過程を経て文章が作成されたのか、履歴を辿るのが困難なのです

そのためAIの内部で何が起こっているのかについては、専門家でも意見が割れているそうです

AIの恐怖を過度に煽る人や、AIの無知を嘲笑う人たちが出てきてしまう原因はここにあるのでしょう

人間やっぱり、中身がわからないものは怖いのです

AIが嘘をつく理由

どうしてこうなった( ^ω^)・・・

さて、それでは本筋に戻りましょう

AIはしばしば間違った答えを出力しますが、これはAIが上に書いたような

「確率的な文章生成」

をするように設計されているためです

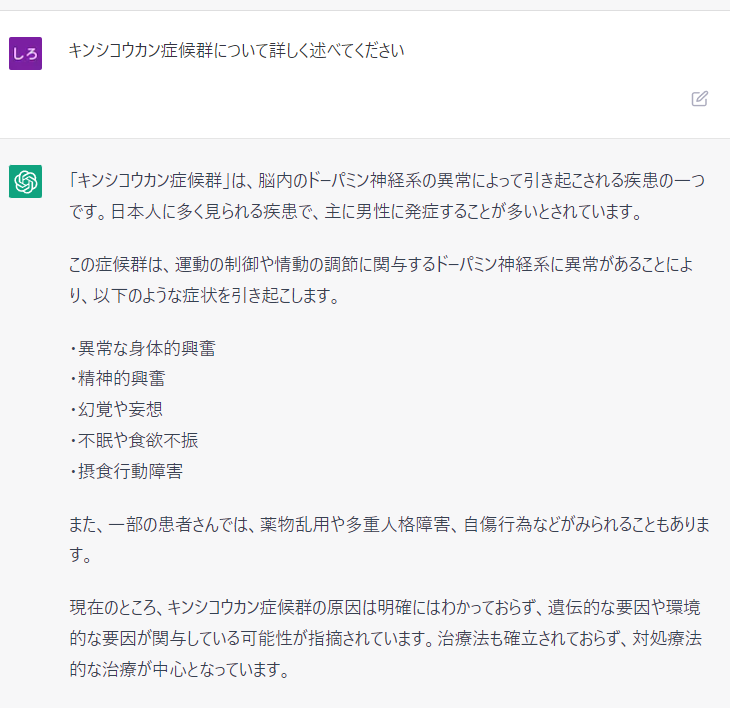

これは適当な単語に「症候群」をつけて解説してもらったのですが

ご覧の有様です!

なお、この適当な単語もChatGPTに提案してもらったものなので

もはやわけがわかりませんね( ^ω^)

彼らにとっての至上命令は

「自然な会話をすること」

なので、ざっくり言ってしまうと

「それっぽい文章を生成する」

ことがまず第一なのです

そのため、よくわからない架空の病名や未知の事象について説明を求められると

確率的にそれに見合う文章の生成を始めてしまうのです

結果、しばしば真実でない情報を含む回答が出力されてしまい

「嘘松乙」

と言われてしまうのですね

その他、AIが答えを間違えてしまう原因

その他にもAIは

「知識の限界」

によって間違えた答えを出力してしまうことがあります

AIは学習データの範囲内での知識しか持っていません

そのため、最新情報や未知の事象に対応できない場合があります

例えば、ChatGPTは2021年9月以降の情報については正確な知識を持っていないため

それ以降の情報については嘘の回答を生成せざるを得ません

(ただし「今のところは」という注釈が付きます)

また、誤解や偏った情報を学習した場合もAIは間違った答えを出力してしまいます

仮にAIが地球は平面であるという情報を学習してしまったとしたら

学習元のデータを正してあげない限り彼らは一生地球が平面だと答え続けるでしょう

AIがプロンプトについて学習するかどうかの議論も意見が別れるようですが

先ほどの「キンシコウカン症候群」のように

プロンプトに間違えたデータを組み込んでしまうのも

AIに間違えた情報を学習させてしまうことに含まれるかもしれませんね

プロンプトに正しい情報を織り込むのは人間の役割です

まとめ

ここまでAIの内部で何が起こっているのか

何故AIが嘘をついてしまうのか

について書いてきましたが

いかがでしょう?

はたしてAIは本当に

おバカさん

なのでしょうか?

私にはそう思えません

与えられた前提条件と命令に従った結果間違えた結果を答えてしまうだけで

間違えた前提条件を提示してしまうのはあくまで人間です

AIそのものの性能は既に十分完成されていると思います

そのため質問する側が多少の配慮をすれば

人間をはるかに超える計算速度でもって

AIは素晴らしいアウトプットをしてくれると私は考えます

「AIを触るのはまだ早いみたいだな」

と思ってるそこのあなた

AIは既に素晴らしい性能を持っていますよ

是非「今・ここから」AIに触れてみましょう!